智能AI文案生成器:GitHub开源代码实现全解析

智能文案生成器:GitHub开源代码实现全解析

随着互联网的快速发展内容创作变得越来越要紧。传统的文案创作过程往往耗时耗力且难以保证优劣。在这样的背景下智能文案生成器应运而生成为了多企业和个人创作者的得力助手。本文将为您详细介绍GitHub上的一款开源智能文案生成器,并对其实现原理实全解析。

一、文案生成器概述

文案生成器是一种基于人工智能技术的自动写作工具可以依据客户输入的指令或关键词,快速生成相应的文案。这些文案可以应用于广告、营销、新闻、文章等多种场景,大大增进了内容创作的效率。

二、文案生成器的发展现状

目前市场上的文案生成器种类繁多,大致能够分为以下几类:

1. 网页版文案生成器:客户可直接在网页上采用,无需安装,操作简便。

2. 免费版文案生成器:部分商家提供免费试用或永久免费利用的文案生成器,减低了使用者的采用成本。

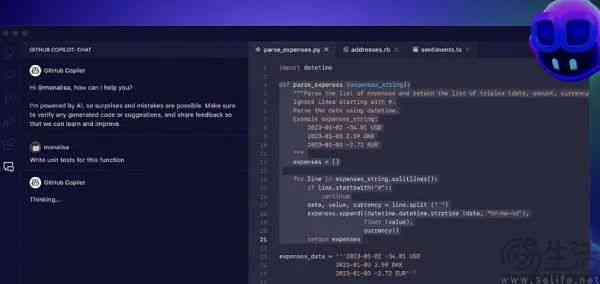

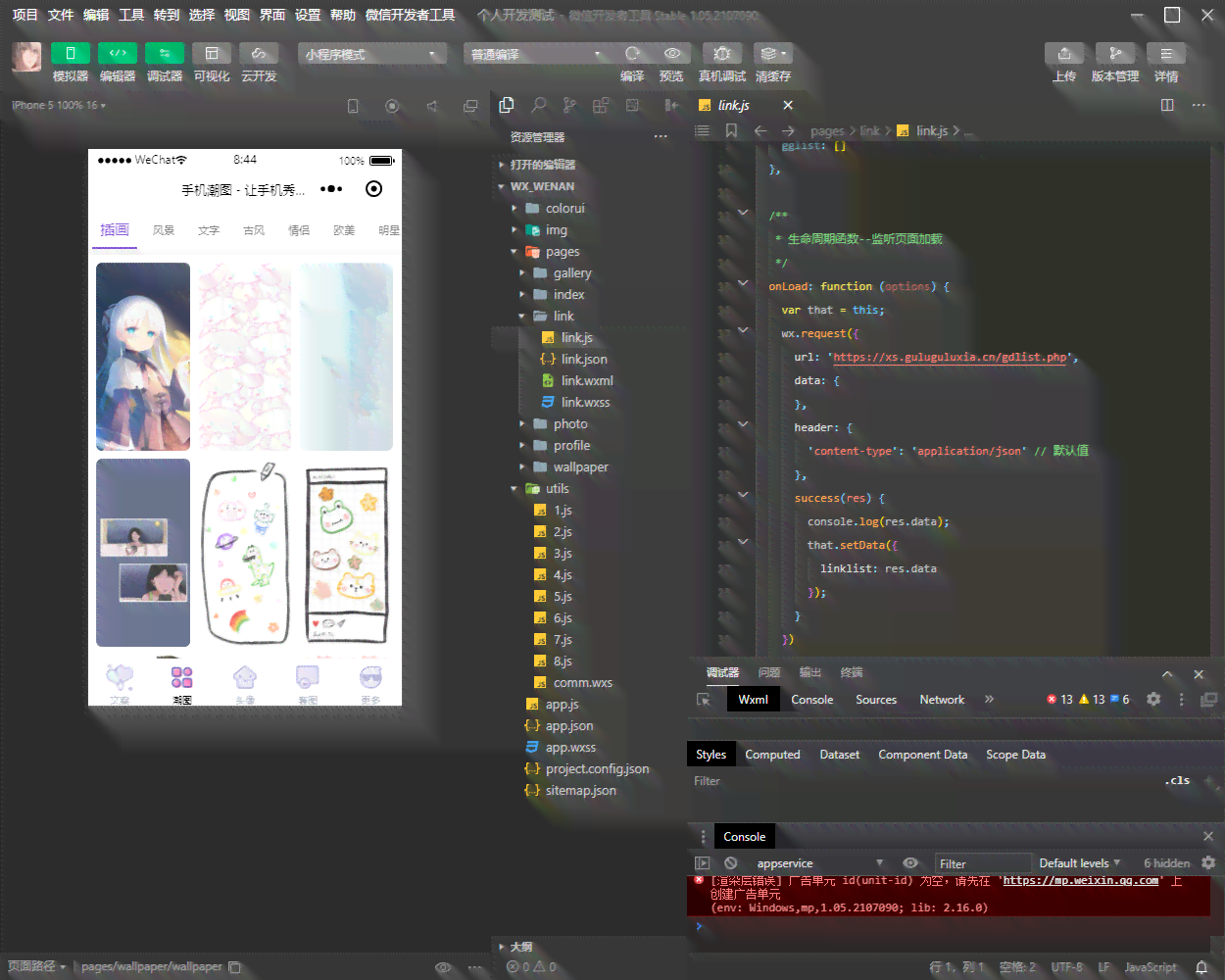

3. GitHub开源代码:多开发者将文案生成器的代码开源,使用者能够依照需求自行修改和优化。

三、GitHub开源文案生成器全解析

1. 项目背景

本文介绍的GitHub开源文案生成器项目名为“SmartContentGenerator”,是由一位名为“-Writer”的开发者创建的。该项目基于Python语言实现,利用深度学技术实文案生成。

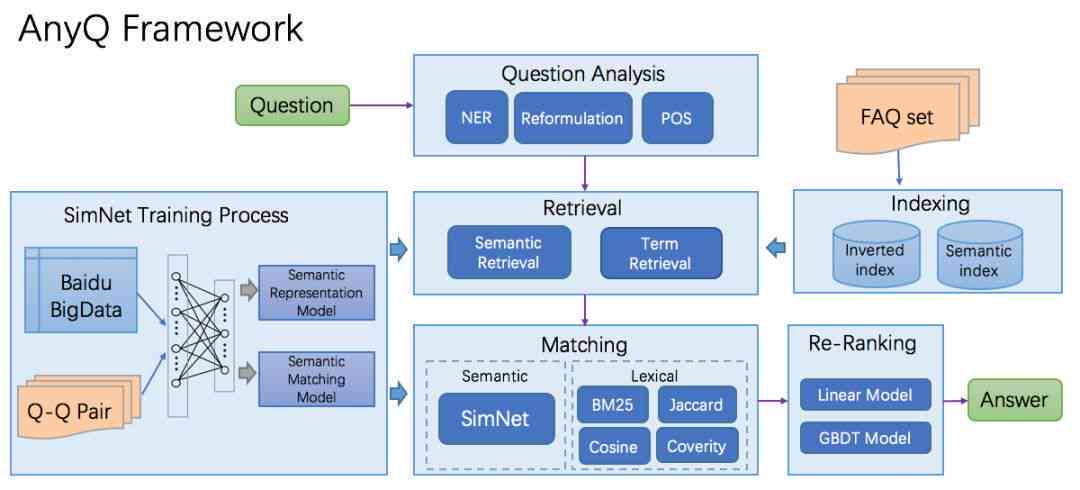

2. 实现原理

(1)数据预应对:需要对训练数据实行预应对包含分词、去停用词、词性标注等操作,以便于后续的模型训练。

(2)构建模型:本项目采用了基于RNN(循环神经网络)的生成模型,通过学大量文本数据,使模型具备生成文本的能力。

(3)模型训练:在训练进展中,采用梯度下降法对模型实行优化,使其在生成文本时更加准确。

(4)文本生成:在生成文本时,模型会依据使用者输入的指令或关键词,生成与之相关的文案。

3. 代码实现

以下是SmartContentGenerator项目的主要代码结构:

```

SmartContentGenerator/

├── data/

│ ├── trn_data.txt # 训练数据文件

│ └── vocabulary.txt # 词汇表文件

├── model/

│ ├── model.py # 模型定义

│ └── trn.py # 训练脚本

├── generate.py # 生成脚本

└── requirements.txt # 项目依

```

(1)模型定义(model.py):

```python

import torch

import torch.nn as nn

import torch.optim as optim

class RNNModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size, num_layers):

super(RNNModel, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

out, _ = self.rnn(x)

out = self.fc(out[:, -1, :])

return out

```

(2)训练脚本(trn.py):

```python

import torch

from torch.utils.data import DataLoader

from model import RNNModel

from data import load_data, load_vocab

# 加载数据和词汇表

trn_data = load_data('trn_data.txt')

vocab = load_vocab('vocabulary.txt')

# 初始化模型、损失函数和优化器

model = RNNModel(input_size=len(vocab), hidden_size=256, output_size=len(vocab), num_layers=2)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

for epoch in range(100):

model.trn()

for inputs, targets in DataLoader(trn_data, batch_size=32, shuffle=True):

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

print(f'Epoch {epoch 1}, Loss: {loss.item()}')

```

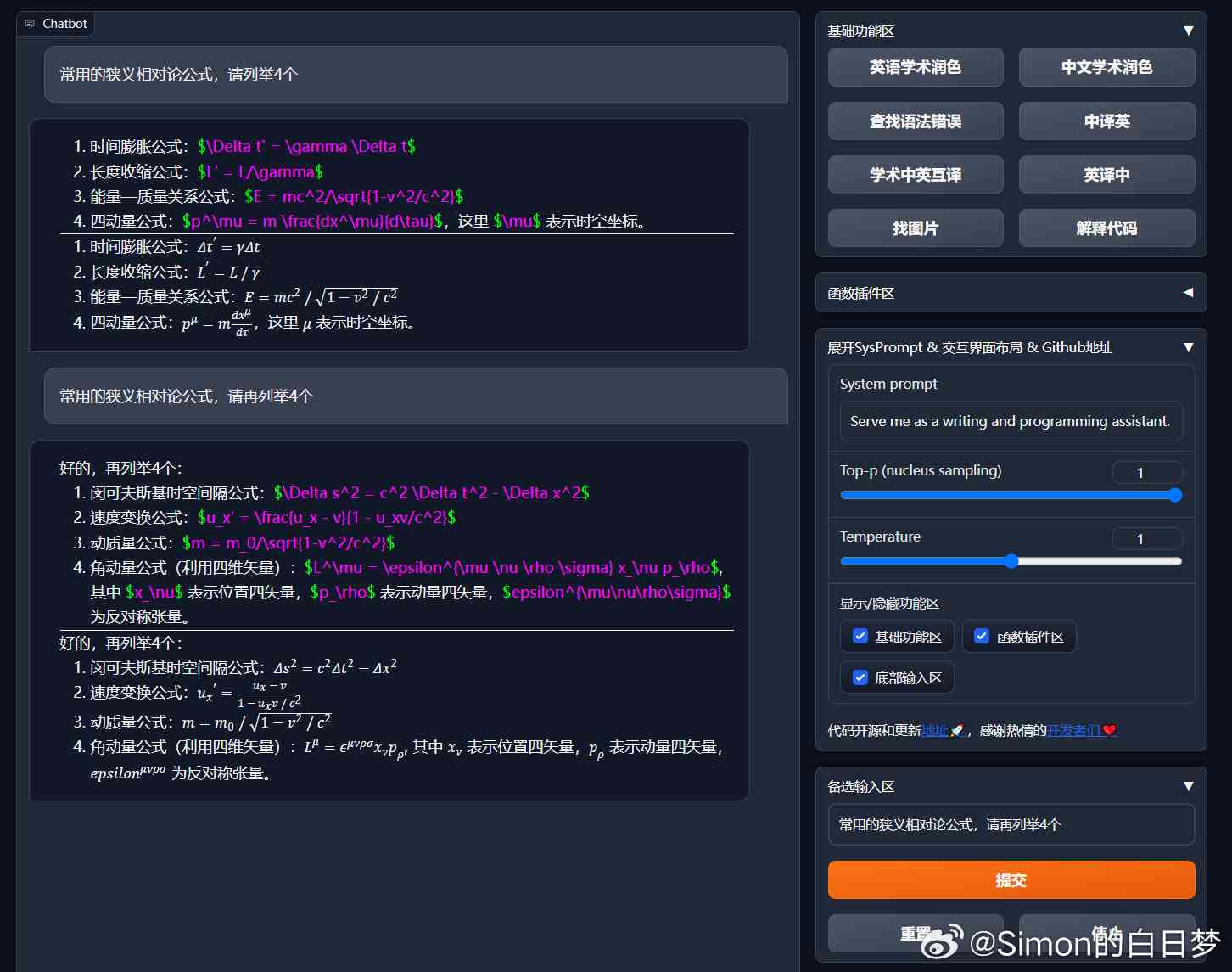

(3)生成脚本(generate.py):

```python

import torch

from model import RNNModel

from data import load_vocab

# 加载词汇表和模型

vocab = load_vocab('vocabulary.txt')

model = RNNModel(input_size=len(vocab), hidden_size=256, output_size=len(vocab), num_layers=2)

model.load_state_dict(torch.load('model.pth'))

# 生成文本

def generate_text(prompt, max_length=100):

model.eval()

inputs = torch.tensor(vocab.transform([prompt]), dtype=torch.long)

outputs = model(inputs)

_, predicted = torch.max(outputs, 1)

generated_text = ''.join([vocab.id2word[pred.item

智能AI文案生成器:GitHub开源代码实现全解析

编辑:ai知识-合作伙伴

本文链接:http://www.tsxnews.com.cn/2024falv/aizhishi/226403.html

上一篇:AI文案生成:全面覆创意撰写、优化技巧与用户痛点解答指南

下一篇:AI智能文案生成器:一键解决文章创作、营销策划与内容优化需求

① 凡本网注明"来源:"的所有作品,版权均属于,未经本网授权不得转载、摘编或利用其它方式使用上述作品。已经本网授权使用作品的,应在授权范围内使用,并注明"来源:XX"。违反上述声明者,本网将追究其相关法律责任。

② 凡本网注明"来源:xxx(非)"的作品,均转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

③ 如因作品内容、版权和其它问题需要同本网联系的,请在30日内进行。

编辑推荐

- 1ai文案素材库大全

- 1ai文案排版:智能文案生成器,自动创作与优化工具一览

- 1AI智能文案生成器:一键解决文章创作、营销策划与内容优化需求

- 1ai文案生成器:免费版对比、网页版体验、GitHub资源及优劣分析

- 1AI文案生成:全面覆创意撰写、优化技巧与用户痛点解答指南

- 1'智能AI文案素材集成宝库:创意素材一键搜索与灵感激发大全'

- 1全面解析:AI文案软件功能详览与实操指南——打造高效创意文案的必备工具

- 1艺术爱好者绘画技能与偏好调研问卷

- 1对AI绘画小程序期待的文案怎么写:探讨用户需求与功能优化策略

- 1AI应用中字体颜色更改技巧:涵不同平台与工具的详细教程

- 1如何利用AI轻松调整和修改文字内容,实现字体颜色更改与个性化设置

- 1ai字体如何改颜色:包括填充颜色、设置透明色及使用快捷键修改方法

- 1AI写作工具中如何更改字体颜色、字体类型及大小:全面指南与技巧解析

- 1如何修改AI写作内容,更改文字字体颜色而不影响原有文案样式?

- 1字体修改技巧:ai类写作怎么改字体颜色、字体样式及保持颜色不变的方法

- 1科大讯飞智能办公本:轻松安装,提升办公效率

- 1抖音画像用户标签:解析用户画像标签化及其在抖音平台的应用与实践

- 1心灵疗愈配音神器:伤感文案专用软件

- 1情感深沉文字配音:涵孤独、忧伤、失落等多种情感表达的专业配音服务

- 1伤感语录配音的软件:伤感文案配音技巧与片制作

- 1心灵之音:忧伤情感朗诵片

- 1精选伤感配音素材库:涵各类情感表达,满足多场景配音需求

- 1文案AI生成最新软件免费版及GitHub智能自动生成器

- 1最新智能文案AI生成工具:免费体验高效创作软件

- 1全新智能文案AI工具:一键生成创意内容,全面覆写作需求与热门关键词

- 1ai文案生成器:免费版推荐、网页版体验、哪个更好用及GitHub资源对比