'探索AI写作模型训练的多种策略与方法'

探索写作模型训练的多种策略与方法

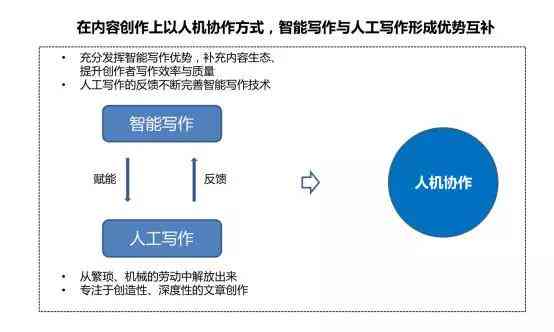

随着人工智能技术的不断发展,写作模型逐渐成为研究的热点。写作模型可以在短时间内生成高品质的文本,为新闻报道、广告文案、小说创作等领域带来革命性的变革。本文将探讨训练写作模型的多种软件、方法和策略。

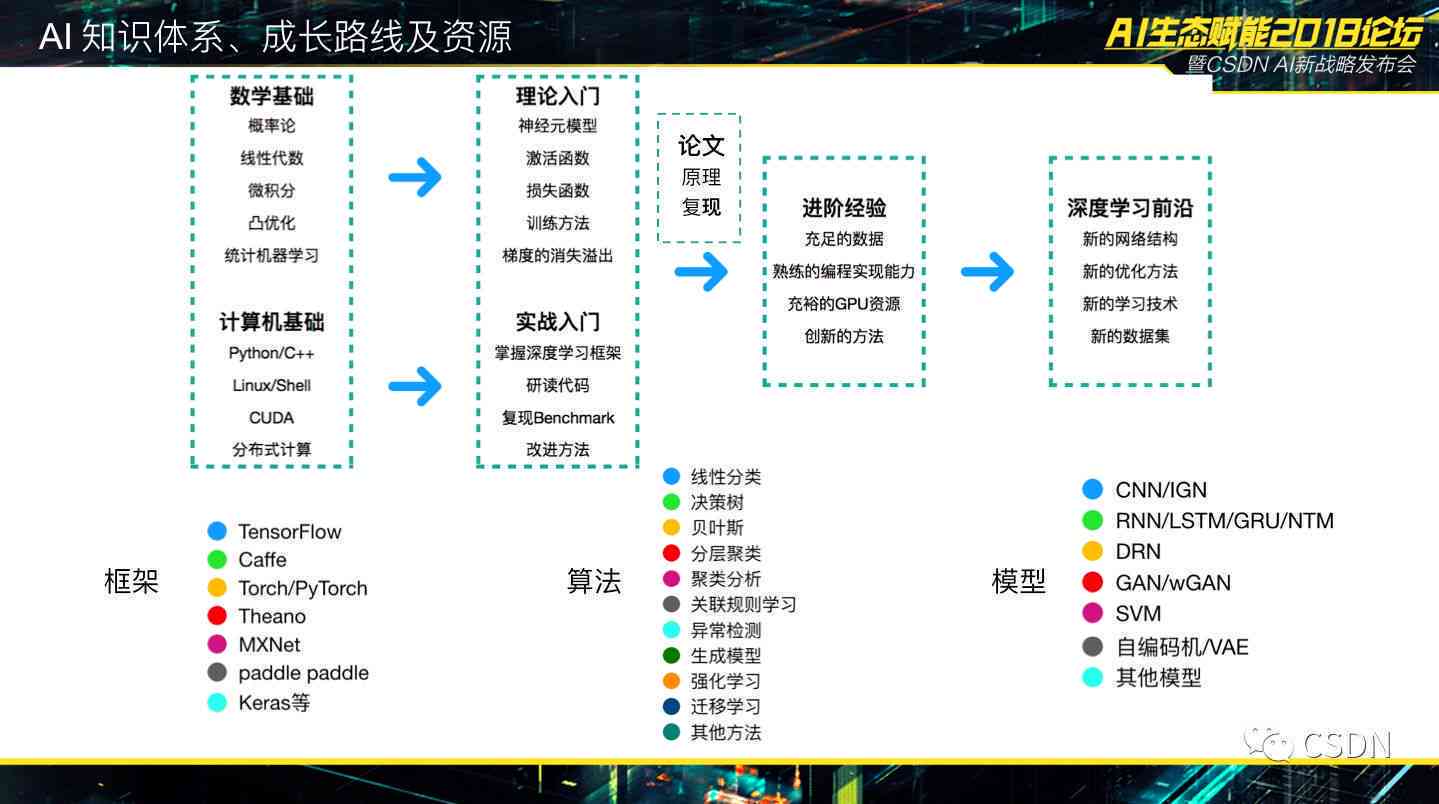

一、训练写作模型的软件

1. TensorFlow

TensorFlow是由Google开发的开源机器学框架,广泛应用于深度学领域。TensorFlow支持多种编程语言,如Python、C 等,具有良好的可扩展性和灵活性。利用TensorFlow,研究者可以轻松搭建和训练写作模型。

2. PyTorch

PyTorch是由Facebook开发的开源机器学库与TensorFlow类似也支持多种编程语言。PyTorch在动态计算图方面具有优势,使得模型训练更加高效。PyTorch的社区活跃提供了丰富的教程和示例代码。

3. Keras

Keras是一个高级神经网络API,可运行在TensorFlow、CNTK或Theano之上。Keras具有简洁的API设计使得搭建和训练模型变得更为简便。对初学者而言Keras是一个很好的入门选择。

4. GPT-2

GPT-2是由Open开发的一款预训练语言模型,基于Transformer架构。GPT-2在自然语言解决任务中取得了显著的成果,能够为写作、翻译等任务提供支持。

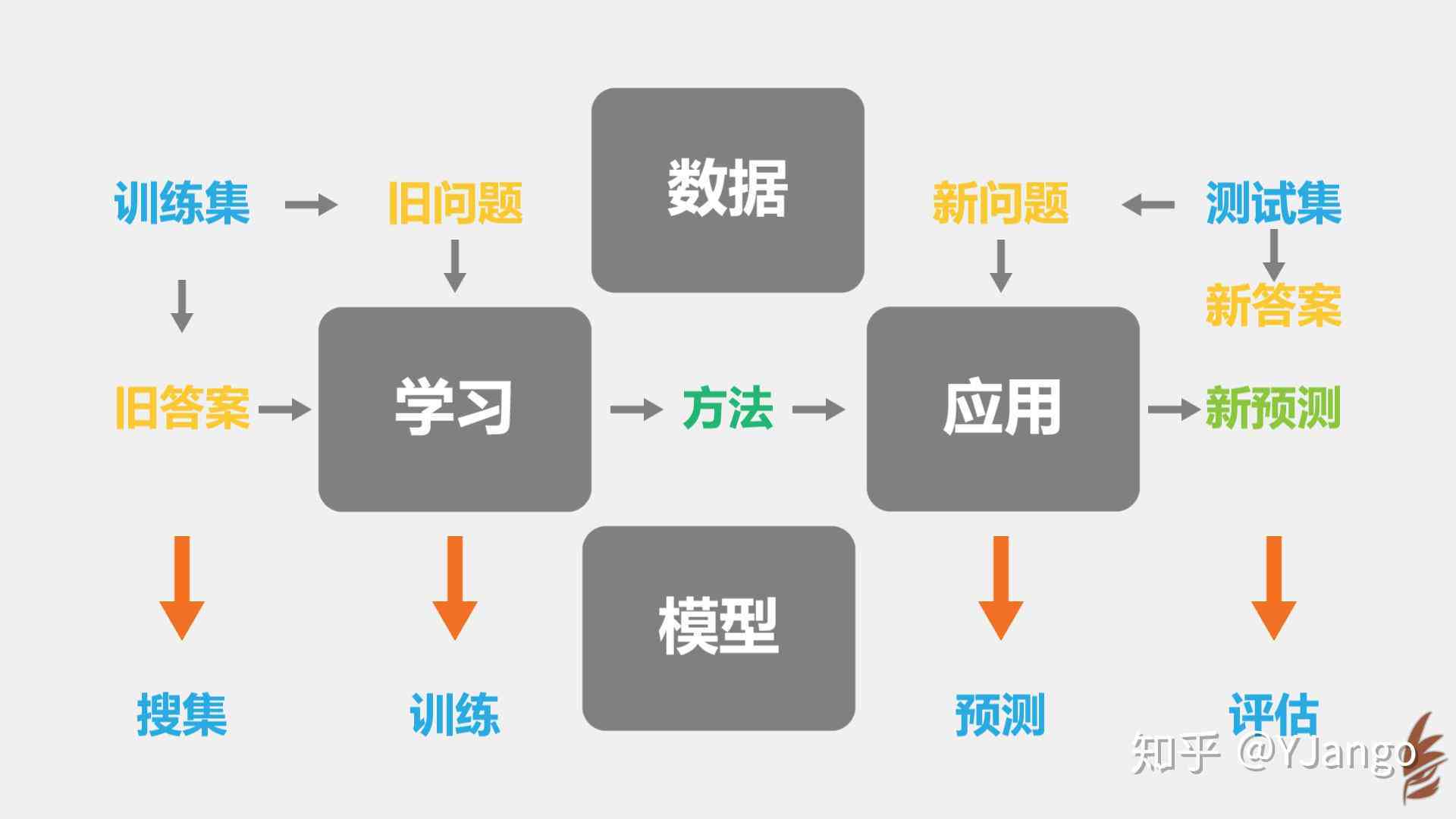

二、训练写作模型的方法

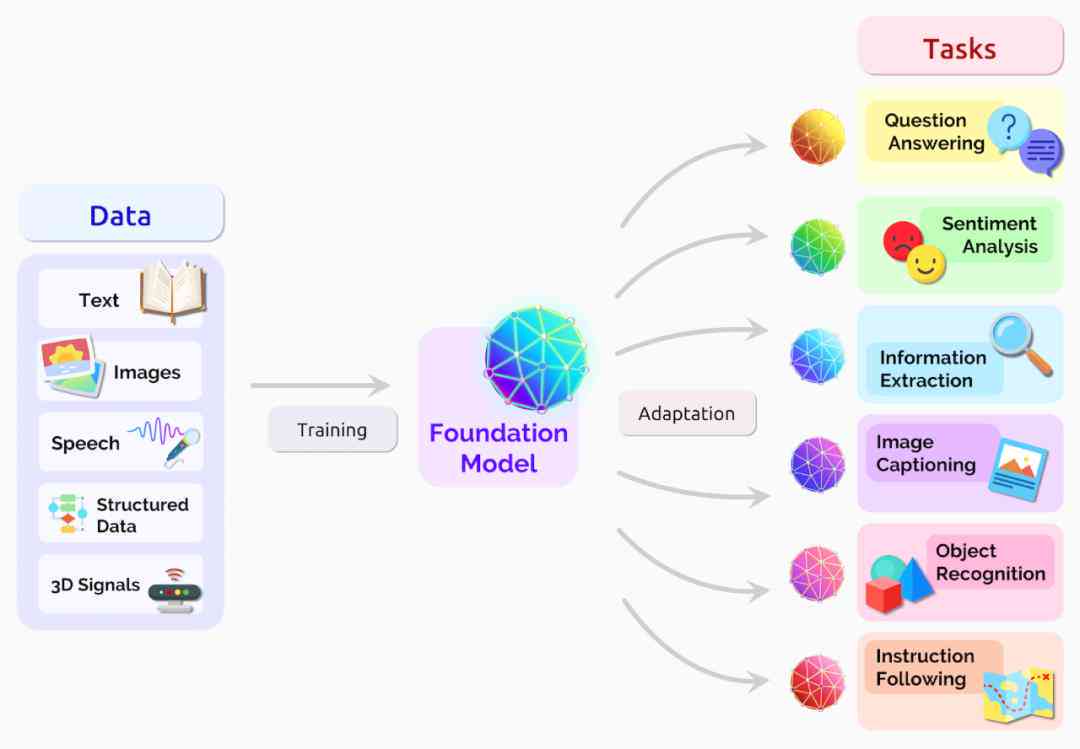

1. 预训练与微调

预训练是指在大规模语料库上训练一个通用模型,然后在此基础上实微调。这类方法可减少训练时间,升级模型性能。例如,GPT-2就是通过预训练在大量文本上,然后针对特定任务实行微调。

2. 数据增强

数据增强是指在训练期间对原始数据实变换从而增加数据的多样性和数量。数据增强方法包含:同义词替换、词语删除、词语替换等。这些方法可帮助模型更好地学语言规律,升级写作能力。

3. 强化学

强化学是一种通过奖励和惩罚来优化模型参数的方法。在写作任务中可将生成的文本与人类写作实对比,依据相似度来给予奖励或惩罚。通过强化学,模型可逐渐优化自身的写作策略。

4. 迁移学

迁移学是指将在一个任务上学到的知识应用到另一个任务上。在写作模型训练中,能够将在一个领域上训练的模型迁移到另一个领域从而升级模型在新领域上的性能。

三、训练写作模型的策略

1. 选择合适的训练数据

训练数据的优劣直接作用模型的效果。在选择训练数据时,应保障数据来源可靠、多样性丰富。还需要对数据实行清洗、去重等预解决操作,以保证数据品质。

2. 设计合理的损失函数

损失函数是量模型性能的关键指标。在设计损失函数时,应考虑以下因素:损失函数应能够反映模型的错误程度,同时具备良好的可导性。常见的损失函数有:交叉熵损失、均方误差等。

3. 调整模型超参数

模型超参数是作用模型性能的关键因素。常见的超参数包含:学率、批次大小、迭代次数等。调整超参数需要按照具体任务和训练数据来实行,常用的方法有:网格搜索、随机搜索等。

4. 模型评估与优化

在训练进展中,需要定期对模型实评估,以熟悉其性能变化。评估指标涵:准确率、召回率、F1值等。针对评估结果,能够采纳以下优化策略:调整模型结构、增加训练数据、改进训练方法等。

总结

本文从训练写作模型的软件、方法和策略三个方面实行了探讨。随着人工智能技术的不断发展写作模型在各个领域的应用将越来越广泛。通过深入研究训练方法和策略,咱们有望进一步提升写作模型的性能,为人类生活带来更多便利。

'探索AI写作模型训练的多种策略与方法'

编辑:ai学习-合作伙伴

本文链接:http://www.tsxnews.com.cn/2024falv/aixuexi/254365.html

① 凡本网注明"来源:"的所有作品,版权均属于,未经本网授权不得转载、摘编或利用其它方式使用上述作品。已经本网授权使用作品的,应在授权范围内使用,并注明"来源:XX"。违反上述声明者,本网将追究其相关法律责任。

② 凡本网注明"来源:xxx(非)"的作品,均转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

③ 如因作品内容、版权和其它问题需要同本网联系的,请在30日内进行。

编辑推荐

- 1训练ai写作模型

- 1深入解析AI写作原理与技术:全面涵生成机制、应用场景与未来发展前景

- 1智能AI写作助手:助力高效内容创作与优化

- 1AI训练文章:揭秘最火一句、样本选择、模型构建及编程语言使用含义解析

- 1全面解析AIDA模型:如何运用AIDA写作技巧提升营销效果与用户吸引力

- 1训练AI写作模型软件:推荐与优劣对比

- 1AI智能创作平 整指南:涵主流工具、使用教程与常见问题解答

- 1'官方AI智能创作大师平台——官网直链体验'

- 1ai智能创作大师 - 官网创作平台安装与智能创作工具获取

- 1AI创作与人类艺术家:未来艺术界将如何融合与创新?

- 1智能少女AI执导:跨界创作科幻影片宴

- 1AI辅助设计:如何利用智能工具创建高效剪切模版

- 1AI文案创作工具:全方位打造原创文章,解决各类写作难题

- 1ai智能写作网站免费:官网推荐、热门平台及英语版本一览

- 1探索抖音热门民族拍照特效:一键换装56个民族服饰,解锁旅拍新潮流

- 1全面解读:AI技术如何深度赋能产品运营与创新策略提升

- 1情侣头像文案类型的头像:制作与配文技巧合辑

- 1打造专属情侣头像:创意文案撰写指南

- 1隐秘示爱的情侣文案:低调表达爱意的方法与技巧

- 1爱情文案不明显:如何撰写含蓄爱情短句与相关文案技巧

- 1'智能AI图像转文案高级创作工具'

- 1AI照片生成高级文案攻略:从技巧到应用,全方位解决创意内容制作难题

- 1ai创作为什么不可用了:探讨其不可用的原因与解决方案

- 1揭秘AI在编辑领域的局限性:为何AI难以胜任编辑工作?

- 1深度解析:AI无法新建内容的原因及常见问题解决方案

- 1AI为什么不能新建画布:探讨新建画板问题的原因