写作神经网络训练:开启智能文本生成的无限可能

随着科技的飞速发展,人工智能技术逐渐深入到各个领域,其中写作神经网络训练作为一种创新技术,正开启智能文本生成的无限可能。本文将从写作神经网络训练的概念、原理和应用等方面实探讨,以期为读者呈现这一领域的前沿动态。

一、写作神经网络训练概述

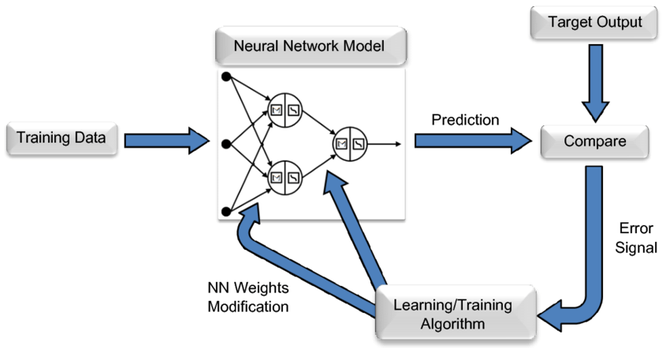

写作神经网络训练是基于深度学技术的一种文本生成方法。它通过训练神经网络模型,使计算机具备自动生成文本的能力。在写作神经网络训练中常用的神经网络结构有循环神经网络(RNN)和长短时记忆网络(LSTM)。这些网络具有强大的序列建模能力可以捕捉文本中的长距离依关系。

二、写作神经网络训练的原理

1. 深度学基础

深度学是一种模拟人脑神经元结构的计算模型,通过多层神经网络对输入数据实行特征提取和分类。在写作神经网络训练中,深度学技术起到了关键作用。

2. 神经网络结构

(1)循环神经网络(RNN):RNN是一种具有短期记忆能力的网络结构,可以对序列数据实分析。RNN在应对长序列时存在梯度消失和梯度爆炸的疑问。

(2)长短时记忆网络(LSTM):LSTM是RNN的一种改进型,它通过引入门控机制,有效应对了RNN在长序列解决中的梯度消失和梯度爆炸难题。

3. 预训练模型

预训练模型是在大规模文本数据上实行预训练的模型,可学到丰富的语言知识和表达方法。近年来预训练模型在写作中得到了广泛应用,如GPT、BERT等。

三、写作神经网络训练的应用场景

1. 小说创作:写作神经网络训练能够自动生成小说,为作者提供创作灵感。

2. 新闻报道:写作神经网络训练自动生成新闻报道,增强新闻写作效率。

3. 广告文案:写作神经网络训练自动生成广告文案,提升广告创意。

4. 论文摘要:写作神经网络训练自动生成论文摘要,节省作者时间。

5. 作文生成:写作神经网络训练自动生成作文帮助学生加强写作水平。

四、写作神经网络训练的优势与挑战

1. 优势

(1)升级写作效率:写作神经网络训练能够自动生成文本,节省作者时间。

(2)宽写作领域:写作神经网络训练可应用于各种类型的文本生成,展写作领域。

(3)减低写作门槛:写作神经网络训练减低了写作的难度使更多人能够参与到写作中来。

2. 挑战

(1)文本品质:写作神经网络训练生成的文本优劣仍有待升级,特别是在语法、语义和逻辑方面。

(2)数据隐私:写作神经网络训练需要大量文本数据实训练怎样保护数据隐私成为一个要紧难题。

(3)可解释性:写作神经网络训练生成的文本难以解释其生成过程,作用了其在某些领域的应用。

五、结语

写作神经网络训练作为一种新兴技术,正开启智能文本生成的无限可能。虽然在文本品质、数据隐私和可解释性等方面仍存在挑战,但随着技术的不断进步,咱们有理由相信写作神经网络训练将在未来发挥更加要紧的作用,为人类写作提供更多可能性。

- ai学习丨最新免ai写作

- ai通丨关于每日ai的文案

- ai知识丨松鼠ai的文案怎么写吸引人

- ai通丨ai免费写作什么好

- ai知识丨ai作画是之一次创作嘛

- ai通丨ai颖照片文案搞笑

- ai通丨永久免费的ai长文写作不限次数

- ai知识丨ai自动文案排版怎么做

- ai学习丨文案ai写作自我介绍范文

- ai知识丨小米ai写作永久免费版

- ai通丨ai文案提问技巧

- ai通丨ai写作灵感机器人

- ai通丨阿里妈妈ai智能文案是什么软件

- ai学习丨国内ai语言进展情况报告

- ai通丨ai写作的写作要求

- ai学习丨ai问答智能创作

- ai学习丨免费ai生成全文写作

- ai通丨ai绘画与手绘实践报告

- ai知识丨ai取代人类文案是什么

- ai通丨ai照片文案高级感